Zoekmachine marketing wordt met de dag complexer. Google neemt nu al meer dan 200 factoren in overweging bij het beoordelen van websites. De verwachting is dat dit er alleen maar meer zullen worden. Voor de internetmarketing leek zijn SEO jargon termen als 404 pagina, linkjuice en NoFollow onbekend. Malafide internetbureaus willen hier nog wel eens misbruik van maken door te strooien met jargon. Door alles vaag en onduidelijk te houden kan men zo de onwetende klant oplichten. In dit opzicht kun je de SEO industrie wel vergelijken met finance. Mooie verkooppraatjes ondersteund door complexe jargon praat om slechte producten en diensten te verkopen. ”We hebben een SAPE domein ge-301-redirect naar uw website om linkjuice over te dragen” Hè? Wablief? Om al die redenen vond ik het broodnodig om een kennisbank te beginnen met alle relevante, belangrijke en essentiële concepten verklaard.

Note: dit is een work-in-progress. Verwacht de komende maanden deze pagina aan te vullen met nieuwe termen, concepten en theorieën. Raad dus aan om deze pagina te bookmarken en zo nu en dan te bezoeken.

0 – 9

200

Status OK – De aanvraag was succesvol. Bijvoorbeeld wanneer een pagina of afbeelding is gevonden en correct wordt weergegeven in de browser.

Sommige slecht ontwikkelde content management systemen geven deze 200-statuscode zelfs wanneer een bestand niet bestaat. De juiste statuscode voor een niet gevonden bestand is 404.

301

Definitief verplaatst – Het bestand is definitief verplaatst naar een nieuwe locatie.

Dit is de beste methode voor de meeste pagina’s of websites om bezoekers om te leiden. Als u een volledige website gaat verplaatsen naar een nieuwe locatie, is het aan te raden om eerst een bestand of map te verplaatsen om te kijken of deze goed scoren in de ranking, alvorens de gehele website te verplaatsen. Afhankelijk van uw site autoriteit en crawl frequency kan het een aantal dagen tot zelfs enkele maanden duren voordat een 301-statuscode wordt opgepikt.

302

Gevonden – Het bestand is gevonden, maar is tijdelijk ondergebracht op een andere URL.

Over het algemeen wordt aanbevolen om 302-statuscodes te vermijden. Sommige zoekmachines hebben moeite met het afhandelen van deze doorverwijzing.

404

Een 404-error is een standaard errorcode die aangeeft dat u verbinding gemaakt heeft met de server van een website, maar dat deze server niet het webadres kon vinden waar u naar op zoek was. Het is een van de meest voorkomende errorcodes op het internet en vaak komt u deze tegen als een webadres niet meer in gebruik is, of wanneer de desbetreffende webpagina offline is gehaald.

404-errors zijn de schrik van iedere webmaster: elke keer als iets veranderd wordt aan de code van een website, moeten zij ervoor zorgen dat ieder webadres werkt met de nieuwe code. Soms wordt weleens iets gemist, waardoor een webadres herleidt naar een ‘lege’ webpagina en u een 404-error te zien krijgt. Als uw klanten bij het bezoeken van uw website een 404-error tegenkomen, kan dit ertoe leiden dat zij uw website vroegtijdig verlaten.

Er is echter een oplossing. Hoewel het misschien niet mogelijk is om alle links op een website actueel te houden (al heeft dat natuurlijk wel de voorkeur), is het mogelijk om de 404-errorpagina te personaliseren. Hierbij kunt u bijvoorbeeld denken aan een bepaalde afbeelding of een verontschuldiging. Een ander idee is om de 404-pagina als sitemap te ontwerpen, waarbij bezoekers doorverwezen worden naar webpagina’s die wel goed functioneren en anders misschien nooit gevonden zouden worden.

De truc is om iets onvermijdelijk negatiefs in iets positiefs te veranderen. Natuurlijk is het zaak om zo secuur mogelijk te zijn bij het up-to-date houden van de links op uw website, maar uitsluiten dat er hierbij nooit iets fout zal gaan is uiteraard onmogelijk. Ervoor zorgen dat zelfs de minst functionele delen van uw website een positieve gebruikservaring leveren, is een kleine moeite die grote impact kan hebben.

A

Above the Fold

Deze term wordt traditioneel gebruikt voor het bovenste gedeelte van een krant. In e-mail of webmarketing betekent dit het gebied waar de inhoud zichtbaar is zonder te scrollen. Sommige mensen definiëren above the fold als ruimte aan de bovenkant van het scherm om te adverteren, maar vanwege banner blindness presteren standaard advertentieruimtes niet meer zo goed als advertenties die in de content verweven zitten. Advertenties die eruit zien als normale content presteren veel beter. Google heeft een zogenaamde top heavy algoritme gelanceerd waarbij het websites straft die overmatig gebruik maken van de advertentieruimte bovenaan.

Alt Attribuut

Blinde mensen en de meeste zoekmachines kunnen u niet duidelijk vertellen wat een afbeelding portretteert. Door een alt-attribuut en bijpassende tekst toe te voegen begrijpen beide partijen beter wat een bepaalde afbeelding inhoudt.

Voorbeeld:

<img src=”http://www.knvb.nl” height=”140″ width=”120″ alt=”Kopdoelpunt van Van Persie” />

Algoritme

Een algoritme is in de basis niets meer dan een eindige set op zichzelf staande instructies. ‘Op zichzelf staand’ betekent dat dat het niet noodzakelijk is om andere processen uit te voeren om het algoritme te berekenen en het gewenste resultaat te krijgen.

De zoekmachinealgoritmes van Google krijgen van SEO (search engine optimization) bedrijven altijd extra aandacht, omdat deze algoritmes bepalen welke positie een website krijgt in de zoekresultaten. Omdat de meeste gebruikers niet verder dan de eerste pagina met zoekresultaten lezen, is het daarom voor bedrijven ontzettend belangrijk om een zo hoog mogelijk genoteerde website te hebben.

Anchortekst

Zoekmachines en gebruikers hebben veel gemeen: allebei vermijden ze websites die geen aan de zoekterm gerelateerde informatie of sleutelwoorden bevatten.

De anchortekst op een website is net als het gebruiken van de juiste sleutelwoorden een onmisbaar onderdeel van SEO (Seach Engine Optimization). Het ultieme doel van iedere online marketeer is het creëren van anchortekst die zoekmachines belangrijk en relevant vinden.

De anchortekst van een website is belangrijker dan deze op het eerste gezicht lijkt. De meeste online marketeers en internetgebruikers zijn al bekend met anchortekst zonder te term te kennen: anchortekst is de tekst van een hyperlink en heeft vaak een andere kleur dan de rest van de tekst op een webpagina. Een andere kleur trekt namelijk meteen de aandacht van de gebruiker.

Websitegebruikers klikken op de anchortekst en worden bijvoorbeeld naar een andere pagina met meer informatie over het onderwerp doorverwezen. Zowel mensen als zoekmachines hebben voorkeur voor webpagina’s met zulke tekstuele links naar andere informatie en zullen deze webpagina’s over het algemeen een hogere beoordeling geven.

Autoriteit

Het vermogen van een pagina of domein om een goede ranking te bemachtigen in zoekmachines. Vijf belangrijke factoren gelinkt aan autoriteit zijn links, leeftijd van de site, bezoekerstrends, geschiedenis en het publiceren van unieke, originele en kwalitatief hoogstaande content.

Zoekmachines stemmen constant hun algoritmes af om de balans te vinden tussen goede autoriteiten in een bepaald (vak)gebied en autoriteiten op het gehele web. Websites kunnen worden gezien als toppers in hun eigen gebied (topical authorities) of toppers op het gehele web (general authorities). Wikipedia en DMOZ bijvoorbeeld kunnen worden gezien als general authorities. ANWB Camping is een topical authority op het gebied van kamperen, maar geen general authority.

Autoriteiten

Topical authorities zijn websites die betrouwbaar zijn en vaak worden geciteerd door experts in die specifieke community. Een topical authority is een pagina die vaak wordt gebruikt door experts en hubsites. Een hubsite is een pagina waar veel wordt verwezen naar verschillende autoriteiten.

Voorbeelden van potentiële topical authorities:

- De grootste merken op jouw gebied

- De grootste blogger die praat over jouw onderwerp

- De Wikipedia of DMOZ-pagina die gaat over jouw onderwerp

B

Blackhat SEO

Blackhat SEO is een verzamelterm voor zoekmachine optimalisatie technieken, concepten en theorieën die vanuit ethisch perspectief ongewenst zijn. Blackhat valt niet in goede aarde bij Google en zal, wanneer betrapt, leiden tot maatregelen (zogenaamde penalty). Je zou blackhat optimalisatie kunnen vergelijken met het nemen van doping voor wielrennen of anabole steroïden bij bodybuilding: middelen die niet geoorloofd zijn die je een oneerlijk voordeel geven over de overige deelnemers. Net zoals bij anabole steroïden zijn er echter lange termijn nadelige effecten. Uiteindelijk zal men toch tegen de lamp lopen. Je kunt in korte tijd veel geld verdienen door met dit soort technieken op nummer 1 te staan in Google, maar wanneer Google je betrapt zal je website een paar pagina’s teruggegooid worden en in het ergste geval helemaal uit de index worden verwijderd.

Maar Romano, kun je dan een aantal praktische voorbeelden geven van Blackhat?

- Het volproppen van je website met zoekwoorden die onzichtbaar zijn voor menselijke bezoekers, maar puur geplaatst zijn voor zoekmachines. Dit doet men door de tekst in de footer te plaatsen in een kleur die gelijk is aan de achtergrond. Mensen zien de tekst dus niet, zoekmachines wel. BMW.de heeft zich hier ooit schuldig aan gemaakt. Zij zijn toen bestraft en een tijdje compleet onzichtbaar geweest in zoekmachines.

- Vervuilen van het internet met geautomatiseerde spam tools zoals SEnuke XCr.

- Hacken van websites om links te injecteren.

Niet doen dus. In sommige gevallen zelfs zeer illegaal. Hacken van websites is immers wettelijk strafbaar. Je kunt er vanuit gaan dat een miljarden bedrijf als Google met honderden PhDs in dienst beter zal gaan worden in het detecteren van blackhat SEO.

Blog

Een blog, ook wel bekend als ‘weblog,’ is een type site waarop gebruikers berichten kunnen plaatsen, vaak aangemaakt door de eigenaar van de site, maar met een dagelijks veranderende groep schrijvers.

Blog Comment Spam

Het handmatig of automatisch (met behulp van een programma) plaatsen van reacties op andere sites die weinig tot niets toevoegen.

Gedurende de jaren zijn zowel handmatige als automatische blog comment spam systemen geëvolueerd, waardoor de reacties steeds authentieker lijken. Ik heb automatische blog comment spam systemen gezien die meerdere nep-personages hebben die met elkaar praten.

Blogroll

Een lijst met voorgestelde blogs die de schrijver plaatst op zijn site om andere, soortgelijke schrijvers aan te raden.

Bounce Rate

Het aantal bevestigde bezoekers die een pagina verlaten zonder naar een andere pagina binnen de site te navigeren. Een andere veel gebruikte term is ‘Abandonment rate.’

Branded Zoekwoorden

Zoekwoorden of zinnen met zoekwoorden geassocieerd met een merk of entiteit. Vaak ziet men branded zoekwoorden pas laat in de koopcyclus en vaak zijn het de meest waardevolle zoekwoorden en zorgen ze voor de hoogste conversie ratio. Dit soort zoekopdrachten kunnen worden gebruikt als relevantie signalen in algoritmes zoals Panda.

Sommige partnermarketingprogramma’s verbieden hun partners om te bieden op de primaire gemerkte zoekwoorden, terwijl anderen het aanmoedigen. Beide manieren kunnen succesvol zijn afhankelijk van het bedrijfsmodel, maar het is belangrijk om er zeker van te zijn dat er een synergie is tussen interne en partnermarketingprogramma’s.

Breadcrumb Navigatie

Een navigatie techniek die gebruikt wordt om zoekmachines en gebruikers van websites te helpen om de relaties tussen verschillende pagina’s beter te begrijpen.

Een voorbeeld van breadcrumb navigatie:

Home > Fruit > Bananen > Chiquita

De pagina waarop de gebruiker zich bevindt is niet gelinkt, maar de bovenliggende pagina’s in de site structuur zijn geordend en gelinkt met de startpagina, helemaal tot onderaan in de site structuur.

Broken Link

Een broken link is een hyperlink die verwijst naar een pagina die niet meer bestaat of verplaatst is. Wanneer men dus klikt op de link zal men terechtkomen op een zogenaamde 404 foutmelding pagina. Dit duidt op een slechte gebruikerservaring. Heb je veel gebroken links op je website dan valt dit dus in slechte aarde bij Google en andere zoekmachines die gebruikerservaring als hoogste prioriteit stellen.

Je kunt broken links checken met tools als Screaming Frog en Xenu’s Link Sleuth. Mijn persoonlijke aanbeveling zou zijn om je website zo nu en dan, zeg maandelijks te controleren met dergelijke tools. Corrigeer de gebroken links vervolgens. Op deze wijze houdt je bezoeker en zoekmachine tevreden.

C

Click-through Rate (CTR)

Het aantal gebruikers dat klikt op een hyperlink gedeeld door het aantal impressions die een link ontvangt.

Cloaking

Een ‘blackhat’ methode gebruikt om webpagina’s te indexeren die afwijken en/of verschillend zijn van wat een bezoeker werkelijk ziet. In principe komt het neer op het aanbieden van een type webpagina aan zoekmachines (om zoekmachine optimalisatie te bereiken) en een ander type aan mensen.

Conversie

Een actie die uitgevoerd wordt door een gebruiker op uw website. Bijvoorbeeld het kopen van iets, inschrijven voor een evenement, aanmelden voor een nieuwsbrief, een webformulier invullen, etc.

Conversie Ratio

Het aantal gebruikers van de site of ad die de gewenste actie voltooien (bijv. een product kopen) gedeeld door het aantal bezoekers.

Canonieke URL

Veel content managementsystemen zijn geconfigureerd met fouten die ervoor zorgen dat dubbele of enorm op elkaar lijkende content wordt geïndexeerd onder meerdere URL’s. Veel webmasters gebruiken inconsistente link structuren door hun hele site, wat ervoor zorgt dat dezelfde content wordt geïndexeerd onder meerdere URL’s. De canonieke versie van een URL is de hoogst geldende versie die geïndexeerd wordt door de grote zoekmachines. Zoekmachines gebruiken normaliter PageRank of een soortgelijke maatregel om te bepalen of een versie van een URL de canonieke versie is.

Webmasters zouden te allen tijde een consistente link structuur in hun sites moeten behouden, om er zeker van te zijn dat ze de maximale aantal PageRank naar hun te indexeren URL’s sluizen. Bij het linken naar het root niveau van een site of naar een folder index, kan men het beste de link locatie beëindigen met een ‘/’ i.p.v. de index.html of de default.asp bestandsnaam in de URL te plaatsen.

Co-citatie

In tegenwoordige authority based zoekalgoritmes kunnen links die in de buurt van elkaar op een pagina verschijnen geacht worden gerelateerd te zijn aan elkaar. In algoritmes zoals latent semantic indexing worden woorden die dichtbij elkaar verschijnen vaak geacht gerelateerd te zijn aan elkaar.

Crawl Frequency

Hoe frequent een website ‘gecrawld’ wordt.

Sites die zeer vertrouwd zijn of frequent bijgewerkt worden kunnen vaker gecrawld worden dan sites met lage betrouwbaarheidsscores en beperkte link authority. Sites met hoge kunstmatige link authority scores (bijv.: voornamelijk spammy links van lage kwaliteit) of sites die ontzettend veel dubbele content bevatten (bijvoorbeeld partner feed sites) kunnen minder vaak gecrawld worden dan sites met unieke content die goed geïntegreerd zijn in het web.

D

Dode Link

Een link die niet meer werkt.

De meeste grote websites bevatten op zijn minst een aantal dode links, maar de verhouding tussen werkende links en dode links kan een indicator zijn van kwaliteit.

Deep Link

Een link die verwijst naar een interne pagina van de website.

Door een natuurlijke toename van het aantal links bevatten de meeste kwaliteitswebsites vele links die naar interne pagina’s verwijzen. Wanneer je andere websites vraagt om naar jouw website te linken, is het logisch om te vragen of ze vanaf hun meest bezochte relevante pagina naar jouw meest bezochte relevante pagina willen linken.

Deep Link Verhouding

Verhouding tussen jouw eigen interne links en het totaal aantal links dat naar jouw website verwijst. Een hoge Deep Link Verhouding duidt in de meeste gevallen op een legitiem en natuurlijk linkprofiel.

De-Listing

Tijdelijk of zelfs permanent verwijderd worden uit een directory of uit de zoekresultaten van een zoekmachine.

De-indexing kan de volgende oorzaken hebben:

- Pagina’s van nieuwe websites (of websites met een lage linkautoriteit in verhouding met hun grootte) kunnen tijdelijk verwijderd worden uit de zoekresultaten tot het moment dat de zoekmachine een ‘deep spidering’ actie uitvoert en het web ‘opnieuw opslaat.’

- Tijdens sommige updates passen de zoekmachines hun zoekprioriteiten aan.

- Je hebt een groot aantal links van hoge kwaliteit nodig om een grote website goed geïndexeerd te krijgen en te houden.

- Dubbele content filters, kwaliteit van inkomende en uitgaande links en andere aan kwaliteitsinformatie gerelateerde issues kunnen ook debet zijn aan aangepaste zoekprioriteiten van de zoekmachines.

- Wanneer een pagina een nieuwe locatie heeft gekregen, maar je links verwijzen nog naar de oude locatie, kan een pagina tijdelijk verwijderd worden wanneer een zoekmachine de pagina’s indexeert.

- Zoekspam:

- Als een website door een automatische spamfilter gevonden wordt, zal deze pas in de zoekresultaten terugkeren zodra het probleem is opgelost. De termijn waarin de pagina terugkeert kan variëren van enkele dagen tot enkele maanden.

- Als een website door een menselijke handeling verwijderd wordt, kan het zijn dat je zelf een aanvraag moet indienen bij de zoekmachine om de website terug te laten keren in de zoekresultaten.

Description (Meta Beschrijving)

Directories en zoekmachines bieden een korte beschrijving bij elk zoekresultaat. Dit doen ze om context toe te voegen aan de titel.

Kwaliteitsdirectories prefereren doorgaans beschrijvingen die vertellen waar de website over gaat en houden niet van promotiemateriaal. Typisch gedrag van zoekmachines:

- Ze gebruiken een beschrijving van een vertrouwde directory (zoals DMOZ of Yahoo! Directory) voor de hoofdpagina’s van websites uit deze directories

- Ze gebruiken de meta beschrijving van de pagina (vooral als deze relevant is voor de zoekopdracht en de woorden van de zoekopdracht bevat)

- Ze proberen een beschrijving van de voor de zoekopdracht en de page ranking relevante content uit de pagina te halen (dit noemen we ook wel een ‘snippet’)

- Of een combinatie van bovenstaande punten

Directory

Een massale lijst met websites die handmatig samengesteld is, in plaats van automatisch.

Sommige directories specialiseren zich in specifieke niche-onderwerpen terwijl andere directories van nature uitgebreider zijn. Grote zoekmachines hebben de neiging om veel waarde te hechten aan links die afkomstig zijn van DMOZ en Yahoo! Directory, en minder waarde aan kleinere en minder bekende directories. Als een directory geen redactionele controles uitvoert op zijn lijsten, dan zullen zoekmachines de links waarschijnlijk niet vertrouwen.

Disavow

Disavow is een tool waarmee websitebeheerders aan kunnen geven dat zij niet garant staan voor een verzameling links naar hun website.

‘Manual link penalties’ zijn sancties die in werking treden nadat een werknemer van Google heeft geconstateerd dat de richtlijnen van Google niet worden nageleefd. Om van deze sancties af te komen moet je in de meeste gevallen de inkomende links van lagere kwaliteit verwijderen en/of ‘Disavowen.’ Voor geautomatiseerde link sancties zoals Penguin geldt dat het gebruik van de Disavow tool voldoende zou moeten zijn om van de sancties af te komen. Echter moet Google de pagina’s wel eerst doorzoeken om de Disavow goed te keuren. Het kan nog steeds een goede zet zijn om een aantal lagere kwaliteitslinks te verwijderen om toekomstig risico op sancties te voorkomen. Door de opkomst van ’negatieve zoekmachine optimalisatie’ kan het voorkomen dat uitgevers in bedrijfstakken met een hoog spamgehalte gedwongen worden om de Disavow tool proactief te gebruiken.

DMOZ

Een door mensen handmatig gecontroleerde directory waarmee websitelijsten gemaakt kunnen worden. DMOZ is de afkorting van directory.mozilla.org en wordt beheerd door Netscape Corporation. Dit is één van de grootste door mensen gecontroleerde web directories.

Doorway Pages

Pagina’s die gemaakt zijn voor populaire zoektermen, vaak om zoekers naar een pagina met advertenties door te verwijzen.

Sommige webmasters verbergen duizenden doorway pages op vertrouwde domeinen en verdienen hier zakken geld mee, totdat ze uit de zoekresultaten verwijderd worden. Als de pagina een uniek doel heeft vinden de zoekmachines het meestal prima, maar als de pagina enkel bestaat omdat de zoekmachines bestaan, zijn de zoekmachines eerder geneigd vraagtekens te zetten bij dit gedrag.

Duplicate Content

Content die hetzelfde, of bijna hetzelfde is als andere content.

Zoekmachines willen niet dat meerdere versies van dezelfde content in de zoekresultaten verschijnen. Een printvriendelijke versie van een pagina zal bijvoorbeeld niet naar voren komen. Bovendien zijn veel geautomatiseerde technieken om content te genereren afhankelijk van het ‘recyclen’ van content. Als reactie hierop zijn sommige zoekmachines enigszins streng in het filteren van content die volgens hen vergelijkbaar of bijna hetzelfde is als andere content.

Dwell Time

Hoe lang iemand op een website blijft voordat hij/zij terugkeert naar de zoekresultaten.

Sommige zoekopdrachten vereisen veel tijd voor een gebruiker om aan de gewenste informatie te komen, terwijl andere zoekopdrachten snel beantwoord kunnen worden door een landingspagina. Dus puur en alleen rekening houden met de ‘Dwell Time’ geeft niet altijd nauwkeurige informatie. Echter kunnen zoekmachines ook andere statistieken meenemen om de gebruikerstevredenheid van een bepaalde website te bepalen. Voorbeelden: gegevens over meerdere bezoeken, zoekopdrachten naar merknamen, relatieve Click Through Rate en/of kijken of gebruikers die op een specifiek zoekresultaat klikken een hoge ’bounce rate’ hebben (door vervolgens op een ander zoekresultaat te klikken). Vervolgens kunnen zoekmachines een algoritme zoals Panda loslaten op deze gegevens.

E

Editorial link

Zoekmachines tellen links als kwaliteitsstemmen. De voorkeur gaat vooral uit naar editorial links en minder naar links die zijn gekocht of geruild. Veel betaalde links, zoals links uit kwaliteitsdirectories, tellen nog wel als stemmen zolang ze nog in verbinding staan met de editorial kwaliteitsstandaard. Als de links afkomstig zijn van sites zonder editorial control, zoals linkfarms, is de kans aanzienlijk dat ze niet bijdragen aan een goede ranking. Door gebruik te maken van algoritmes zoals TrustRank, geven sommige zoekmachines de voorkeur aan bekendere sites die voorzien zijn van duidelijke redactionele richtlijnen.

Engagement Metrics

Zoekmachines kunnen het gedrag van de eindgebruiker analyseren om hun rankings aan te scherpen en te verbeteren. Sites die een hoge doorklik hebben en een hoog aantal herhaalde bezoeken van merkgerelateerde zoekopdrachten kunnen een rankingboost krijgen in algoritmes zoals Panda.

Entiteiten

Mensen, plaatsen of dingen die zoekmachines willen kennen of weten en waar ze achtergrondinformatie over willen presenteren. Merken zijn een populaire vorm van entiteiten, maar ook andere informatiesoorten zoals liedjes of films kunnen entiteiten zijn. Informatie over entiteiten kan worden getoond in knowledge graph resultaten.

Entry Page

De pagina waarop een gebruiker jouw site binnenkomt. Als je pay per click advertenties gebruikt is het belangrijk om de bezoekers naar de meest relevante en doelgerichte pagina te sturen, die overeenkomt met de keyword waarnaar ze zochten. Als je aan link building doet is het belangrijk om waar mogelijk je links te richten naar de meest geschikte pagina, zodat:

- als iemand op de link klikt ze doorgestuurd worden naar de meest geschikte en relevante pagina

- je zoekmachines kunt helpen te begrijpen waarmee de pagina’s van jouw site geassocieerd kunnen worden

Expired Domains

Expired Domains zijn domeinnamen die verlopen zijn. Iedereen die ooit een domeinnaam heeft gekocht zal ongetwijfeld weten dat je een domeinnaam voor één of meerdere jaren kunt registreren. Wanneer je de domeinnaam niet bijtijds verlengt zal je de rechten op gebruik van de betreffende domein kwijtraken. Het domein zal dan een proces ondergaan wat verschilt per extensie (.nl, com, .es etcetera). Meestal wordt de domeinnaam eerst in quarantaine geplaatst en is er een periode waar de oorspronkelijke eigenaar aanspraak kan maken op het domein tegen extra kosten voordat deze vrijgegeven wordt. Ten slotte, is het domein weer beschikbaar voor iedereen om te registreren.

Stel je voor dat ik SEOGeek.nl vergeet te verlengen. Ik heb een ongeluk gehad of iets dergelijks en ben buiten bewustzijn voor een anderhalf jaar. Anderzijds kan het zijn dat de onderneming financieel niet werkt en ik er mee stop. Ik zal de domein dus niet verlengen want ik hang SEOgeek aan de wilgen op. Domein zal verlopen. Ik maak ook geen aanspraak tijdens quarantaine. Domein wordt vrijgegeven. Pietje registreert het domein en kan nu gebruik maken van SEOGeek.nl. Pietje kan verder op de domeinnaam SEOGeek.nl en profiteert van de SEO autoriteit die ik de laatste jaren vergaard heb. Pietje komt terecht in een gespreid bedje. Dit is immers een veel gunstigere situatie dan wanneer hij helemaal vanaf het begin moest starten met een gloednieuwe domeinnaam, PietjeSEO.nl.

Belangrijk om te vermelden is dat verlopen domeinnamen de laatste jaren erg populair zijn geworden om in te zetten als SEO tactiek. Bepaalde zoekmachine optimalisatie partijen speuren domeinnaam markten, veilingen en collecties af op zoek naar waardevolle domeinnamen vanuit SEO perspectief. Die domeinnamen schaffen zij aan en restaureren die. Op die domeinen plaatsen zij vervolgens backlinks naar eigen website(s) en/of de website(s) van klanten. Dit zou helpen om SEO autoriteit over te dragen aan de website waar naar gelinkt wordt. De reden waarom dit zo aantrekkelijk is voor die partijen is omdat zij volledige controle hebben over de domeinen en dan specifiek hoe gelinkt wordt naar eigen website(s).

Externe Link

Link die refereert naar een ander domein.

Sommige mensen geloven in link hoarding, maar naar buiten linken naar andere gerelateerde bronnen is een betere manier om zoekmachines te laten begrijpen waar jouw site over gaat. Als je naar veel sites linkt van lage kwaliteit of enkel vertrouwt op wederzijdse links van lage kwaliteit, is de kans aanwezig dat jouw site niet hoog gerankt wordt door zoekmachines. Zoekmachines vertrouwen liever op editorial links van hoge kwaliteit (zowel van als naar jouw site).

F

Forum

Een online hub waar gebruikers kunnen communiceren door middel van discussies, posts, comments, borden etc. Fora worden meestal opgezet om service te bieden aan klanten of om een fan hub te maken.

Filter

Bepaalde activiteiten of signatures die een pagina of site onnatuurlijk laten overkomen geven zoekmachines de neiging om deze te filteren of te verwijderen uit de zoekresultaten. Als een site bijvoorbeeld een significante hoeveelheid dubbele content publiceert kan dit ervoor zorgen dat de site een verminderde crawl prioriteit krijgt en uit de zoekresultaten gefilterd wordt. Sommige zoekmachines hebben ook filters die gebaseerd zijn op linkkwaliteit, linkgroeipercentage, en anchor tekst. Sommige pagina’s worden ook gestraft voor spammen.

Fresh Content

Content die van nature dynamisch is en die mensen een reden geeft om aandacht te blijven besteden aan jouw website, of content die recentelijk gepubliceerd is. Veel SEO’s hemelen fresh content op, maar fresh content staat over het algemeen niet voor de herbewerking van oude content. Het refereert eigenlijk vooral naar het maken van nieuwe content. De grootste voordelen van fresh content zijn:

• Behouden en uitbreiden van mindshare: Als je ervoor zorgt dat je mensen elke keer een nieuwe reden geeft om op jouw site te blijven letten zullen steeds meer mensen aandacht aan jou besteden en linken naar jouw website.

• Snellere idee verspreiding: als veel mensen aandacht besteden aan jouw website, dan zullen je nieuwe goede ideeën zich snel verspreiden.

• Archieven opbouwen: Als je een content producent bent dan betekent het dat hoe meer content je bezit, hoe meer kansen je krijgt om gerankt te worden. Als je steeds aanvullende fresh content blijft produceren, zul je uiteindelijk een grote catalogus krijgen met relevante content.

• Frequent crawling: Frequent geüpdatete websites hebben een grotere kans op crawlers.

• QDF: De Query Deserves Freshness algoritme van Google kan de rankings boosten van een recent gepubliceerd document door zoekopdrachten die, volgens Google, door gebruikers worden ingetikt als ze op zoek zijn naar relevante informatie.

Het grootste risico van het maken van veel ‘fresh’ content omwille van de zoekresultaten, is dat veel goedkope content bronnen slechte engagement metrics hebben, wat kan leiden tot bestraffing van de site door Panda. Een vraag die je jezelf vooraf kunt stellen is: als je niet de eigenaar van je website zou zijn, zou je deze dan nog steeds bezoeken en de nieuwe content lezen die erop gepubliceerd is.

Fuzzy Search

Zoekopdracht die matchende termen vindt, als deze verkeerd gespeld zijn (of fuzzy). Fuzzy zoektechnologie lijkt op stamtechnologie, met uitzondering dat fuzzy search de verkeerd gespelde woorden corrigeert bij de kant van de gebruiker en stamtechnologie zoekt naar andere versies van hetzelfde kernwoord binnen de index.

G

GoogleBot

Google’s zoekmachine spider.

Google heeft een gedeelde crawl-cache voor hun verschillende spiders, inclusief de verticale zoekspiders en de spiders geassocieerd met advertentiegericht zoeken.

Google Dance

In het verleden maakte Google ruwweg maandelijks een update van hun index. Deze updates werden Google Dances genoemd, maar nadat Google is begonnen met een constant updatende index, doet Google niet langer wat traditioneel de Google Dance genoemd werd.

De belangrijkste zoekindices zijn continu aan het updaten. Google refereert aan deze continue verversing als everflux.

De tweede betekenis van Google Dance is een jaarlijks feest op Google’s algemene hoofdvestiging dat Google geeft voor zoekmachinemarketers. Dit feest valt samen met de San Jose Search Engine Strategies conferentie.

Google Supplementaire Index

Een index waar pagina’s met lagere betrouwbaarheidsscores worden opgeslagen. Pagina’s kunnen worden geplaatst in Google’s Supplementaire Index als ze vooral bestaan uit gekopieerde inhoud, als de URLs buitensporig ingewikkeld van aard zijn, of als de site die de pagina’s herbergt niet voldoende vertrouwd wordt.

Google Trends

Een gereedschap waarmee je kunt zien hoe de zoekvolumes van Google voor een bepaald zoekwoord over tijd veranderen.

H

Heading

Het kopelement beschrijft kort het onderwerp van het hoofdstuk dat het introduceert.

Kopelementen gaan van H1 tot H6 waarbij de koppen met het laagste cijfer het belangrijkst zijn. U hoort slechts één enkel H1 element per pagina te gebruiken en u zou meerdere andere kopelementen kunnen gebruiken om een document in te delen. De bron van een H1 kopelement zou er zo uit moeten zien:

<h1>Uw Onderwerp</h1>

Kopelementen kunnen worden vormgegeven met gebruik van CSS. Veel contentmanagementsystemen plaatsen dezelfde inhoud in de hoofdpaginakop en de paginatitel, hoewel het in veel gevallen de voorkeur geniet ze door elkaar te gebruiken indien mogelijk.

.htaccess

Een Apache mapniveau configuratiebestand dat kan worden gebruikt om bestanden met een wachtwoord te beschermen of bestanden door te sturen.

Een waarschuwende noot: zorg ervoor dat u een kopie maakt van uw huidige .htaccess bestand voordat u het gaat wijzigen, en wijzig het niet voor een site waarvan u het u niet kan veroorloven als deze down gaat, tenzij u weet wat u doet.

I

Interne Link

Link van de ene pagina op een site naar een andere pagina op dezelfde site.

Het heeft de voorkeur om beschrijvende interne linking te gebruiken om het gemakkelijker te maken voor zoekmachines te begrijpen waar uw website over gaat. Wees consistent in het gebruik van ankerteksten voor de navigatie voor elk onderdeel van uw site, terwijl u andere pagina’s binnen die sectie benadrukt. Plaats links naar relevante pagina’s binnen het inhoudsgebied van uw site om de relatie tussen de pagina’s van uw site beter te laten zien en de bruikbaarheid van uw site te verbeteren.

J

JavaScript

Een client-side scripttaal die in HTML documenten ingebed kan worden om dynamische aspecten toe te voegen.

Zoekmachines indexeren de meeste inhoud in JavaScript niet. In AJAX, wordt JavaScript gecombineerd met andere technologieën om webpagina’s nog interactiever te maken.

K

Keyword

Een woord of zin dat een bepaalde mentaliteit of vraag impliceert waar doelgerichte gegadigden waarschijnlijk op gaan zoeken.

Long tail en merk zoekwoorden zijn normaal gesproken waardevoller dan kortere en vagere zoekwoorden omdat ze in het algemeen later in de buying cycle voorkomen en geassocieerd zijn met een hoger niveau van geïmpliceerde bedoeling.

Keyword Density

Een oude maat voor de zoekmachinerelevantie gebaseerd op hoe prominent zoekwoorden verschenen in de inhoud van de pagina. Zoekwoordendichtheid is echter niet langer een geldige maat voor de relevantie in een brede open zoekindex.

Als mensen stukken propvol zoekwoorden gebruiken dan neigt het naar mechanisch lezen (en wordt het dus niet goed omgezet en is daarmee niet linkwaardig), plus dat sommige pagina’s zijn gemaakt met slechts het belangrijkste zoekwoord in gedachten en die vaak een gebrek hebben aan semantisch verwante woorden en stabilisatoren uit een verwant vocabulair (en dat zorgt ook dat de pagina’s een lage ranking krijgen).

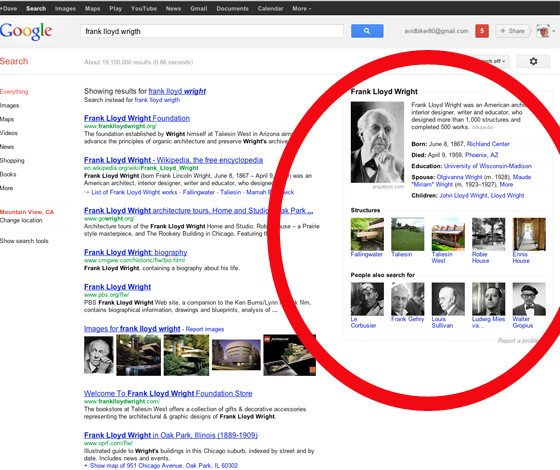

Knowledge Graph

Versterking van zoekresultaten waar Google informatie van derden bij elkaar schraapt en het in een uitgebreid formaat toont in de zoekresultaten.

Het doel van de knowledge graph is voornamelijk drievoudig:

- Het snel beantwoorden van vragen zonder hiervoor uit de zoekresultaten te moeten gaan, in het bijzonder voor eenvoudig te beantwoorden vragen over bekende entiteiten.

- Verdringen van de set organische zoekresultaten door deze verder naar beneden op de pagina te verplaatsen, hetgeen ook weer een stijging van de doorklikpercentages kan veroorzaken op de advertenties die boven de knowledge graph getoond worden.

- Sommige knowledge graph vermeldingen (zoals zoekopdrachten voor hotels, boeken, liedjes, liedteksten) bevatten ook links naar andere Google eigenschappen of andere vormen van advertenties daarbinnen, die het genereren van inkomsten van de zoekresultaatpagina verder stimuleren.

L

Link

- Een citatie van het ene webdocument naar een ander webdocument of een andere positie in hetzelfde document.

- De meeste grote zoekmachines beschouwen een link als een blijk van vertrouwen.

Link Baiting

- De kunst van het mikken op, creëren en vormgeven van informatie dat ervoor zorgt dat de doelgroep met hoge-kwaliteitslinks naar uw site verwijzen. Veel link baiting technieken zijn gericht op social media en bloggers.

Link Farm

Een website of groep van websites die weinig of geen redactionele controle uitoefenen als ze naar andere sites linken. FFA pagina’s bijvoorbeeld, zijn link farms.

Linksnelheid

De mate waarin een pagina of website nieuwe inkomende links accumuleert.

Pagina’s of sites die een enorme piek van nieuwe binnenkomende links binnen een korte tijd ontvangen kunnen automatische gefilterd worden en/of gemarkeerd worden voor handmatige redactionele beoordeling door zoekingenieurs.

LSI

Latent Semantic Indexing is een manier voor zoeksystemen om mathematisch te begrijpen en vertegenwoordigende taal gebaseerd op de overeenkomst van het samen voorkomen van pagina’s en zoekwoorden. Een relevant resultaat kan zelfs niet eens het zoekwoord bevatten. Het kan worden weergegeven slechts gebaseerd op het feit dat het veel soortgelijke woorden heeft als die in relevante pagina’s voorkomen die wel de zoekwoorden bevatten.

M

Manual Penalty

Straffen die toegepast worden op een website als een medewerker van Google bepaald heeft dat deze website de Google Webmaster Guidelines gebroken heeft. Herstel na een dergelijke straf kan enkele jaren duren, maar men kan ook een herziening aanvragen in Search Console als men denkt dat het probleem verholpen is.

Als een website een handmatige straf gekregen heeft, is vaak een waarschuwing in Search Console te zien. Bij een automatische straf van Panda of Pinguin is dit niet het geval.

Manual Review

Alle grote zoekmachines combineren een handmatig beoordelingsproces met geautomatiseerde algoritmes om spam te voorkomen en de algoritmes te verbeteren. Abnormaal dataverkeer of vreemde linkbuilding-patronen kunnen ervoor zorgen dat een website gemarkeerd wordt voor handmatige beoordeling.

Metabeschrijving

Een metabeschrijving is een beschrijving van de inhoud van een pagina in een of twee zinnen.

Een goede metabeschrijving:

- Is relevant en voor iedere pagina uniek;

- Versterkt de titel van de pagina; en

- Bevat secondaire sleutelwoorden en zinnen die de paginatitel van extra content voorzien.

Relevante metabeschrijvingen kunnen in de zoekresultaten verschijnen als onderdeel van de paginabeschrijving, onder de titel van de pagina.

De code van een metabeschrijving ziet er als volgt uit:

<meta name=”Beschrijving” content=”Vul hier de metabeschrijving in.”/>

Meta keywords

De meta keywords-tag is een tag die gebruikt kan worden om bepaalde sleutelwoorden en –zinnen te highlighten op een webpagina.

De code voor een meta keyword-tag ziet er als volgt uit:

<meta name=”Keywords” content=”sleutelzin, sleutelwoord, sleutelwoord, sleutelwoord, et cetera”>

In het verleden hebben veel mensen misbruik gemaakt van de meta keyword-tag om zoekmachines om de tuin te leiden. Tegenwoordig hechten zoekmachines en SEO-professionals daarom weinig tot geen belang meer aan de meta keyword-tag.

Meta tags

Over het algemeen worden metabeschrijvingen en meta keywords ‘meta tags’ genoemd. Sommige mensen classificeren de titel van een webpagina eveneens als een meta tag.

- De titel van de webpagina is het meest belangrijk;

- De metabeschrijving van de pagina is belangrijk;

- De meta keywords-tag is niet belangrijk.

N

Negatieve SEO

Proberen de zoekmachine-ranking van een andere website negatief te beïnvloeden.

Veel linkbuilding-strategieën worden na verloop van tijd door Google gedegradeerd van ‘white hat’ naar ‘gray hat’ en uiteindelijk ‘black hat’. Een concurrent of reputatiemanager kan een aantal links van lage kwaliteit met agressieve anchor-teksten naar een bepaalde pagina herleiden, om ervoor te zorgen dat deze pagina uit de zoekresultaten verwijderd wordt. Als deze links een handmatige straf veroorzaken dan moet de webmaster van de bestrafte webpagina zich niet alleen distantiëren van deze links, maar eventueel ook andere links verwijderen die ex-post-facto als ‘black hat’ geclassificeerd worden. Er zijn ook negatieve SEO-strategieën die geen gebruik van links maken.

NoFollow

NoFollow is een attribuut dat gebruikt wordt om te voorkomen dat links waardevolle doorverwijzingen naar andere pagina’s geven. Vaak wordt dit attribuut gebruikt bij websites met door gebruikers gegenereerde content, zoals commentaren op een blogpost.

De code om nofollow te gebruiken ziet er als volgt uit:

<a href=”https://seogeek.nl” rel=”nofollow”>anchortekst</a>

NoFollow kan ook gebruikt worden in een robots meta tag om te voorkomen dat een zoekmachine het aantal uitgaande links op een webpagina kan tellen. Deze code ziet er dan als volgt uit:

<meta name=”robots” content=”index, nofollow”>

Matt Cutts

Voormalig medewerker bij Google, spoort webmasters aan om NoFollow te gebruiken voor betaalde links. Google is zelf echter de grootste linkmakelaar ter wereld, dus dit advies moet met een korreltje zout genomen worden. Het is over het algemeen niet aan te bevelen om zo veel mogelijk links te verzamelen, omdat dit als onnatuurlijk over kan komen. Uitgaande links kunnen in sommige zoekmachines ook voor een hogere relevantiescore zorgen.

O

Organische zoekresultaten

De meeste grote zoekmachines laten zoekresultaten zien die bestaan uit betaalde advertenties en onbetaalde resultaten. Deze onbetaalde (algoritmische) resultaten worden ook wel organische zoekresultaten genoemd. Organische zoekresultaten worden geordend naar relevantie, wat grotendeels bepaald wordt door linkdata, de content van de pagina, gebruiksstatistieken en gerelateerde historische data.

De meeste clicks gaan naar organische zoekresultaten; sommige studies hebben aangetoond dat dit zelfs zestig tot tachtig procent van het totaalaantal clicks is.

Outbound link

Outbound of uitgaande links zijn links van de ene website naar een andere, externe website.

Sommige webmasters geloven in link hoarding, het verzamelen van grote aantallen inkomende links, maar uitgaande links kunnen net zo effectief zijn om de zoekmachine te helpen begrijpen waar een website over gaat. Refereren aan andere bronnen komt tevens de geloofwaardigheid van een website ten goede. Sommige webmasters houden bij waar gebruikers vandaan komen. Uitgaande links aanbieden naar andere websites kan er dus ook voor zorgen dat zij sneller terugkerende links zullen plaatsen.

P

PageRank

PageRank is een logaritmische schaal die de relevantie van webpagina’s bepaalt aan de hand van linkwaardes.

Omdat Google’s PageRank-algoritmes eenvoudig te manipuleren waren, hecht het bedrijf er tegenwoordig weinig waarde meer aan. In plaats daarvan is Google meer gaan letten op geverifieerde links via algoritmes als TrustRank.

De PageRank-formule is:

PR (A) = (1-d) + d (PR(T1) / C (T1) + … + PR (Tn) / C (Tn))

En…

PR = PageRank

d = dempfactor (plm. 0,85)

c = aantal links op een pagina

PR (T1) / C (T1) = PageRank van pagina 1 gedeeld door het totaal aantal links op pagina 1. Ook wel ‘transferred PageRank’ genoemd.

In woorden: voor een pagina A is de PageRank PR (A) gelijk aan de som van de gedeeltelijke PageRank van iedere andere pagina die naar pagina A doorverwijst, vermenigvuldigd met de dempfactor plus één min de dempfactor.

Panda-algoritme

Het Panda-algoritme is een algoritme van Google dat probeert om websites in ‘mandjes’ te plaatsen op basis van de kwaliteit van webpagina’s. Signalen waar het Panda-algoritme naar kijkt zijn onder meer het linkprofiel van een website en gerelateerde zoekopdrachten.

Websites met veel maar weinig diepgaande content (bijvoorbeeld eHow), veel advertenties, weinig terugkerende bezoekers en hoge ‘bounce rates’ krijgen dankzij Panda een lagere rating, terwijl vertrouwde websites van bekende merken (bijvoorbeeld Amazon) een hogere waardering toebedeeld krijgen. De introductie van Panda heeft veel gevolgen gehad voor artikeldatabases en andere zogeheten ‘content farms’ die door dit nieuwe algoritme hun ranking in de zoekresultaten zagen kelderen.

Penalty

Zoekmachines voorkomen dat websites die bijvoorbeeld verdacht worden van het verspreiden van spam hoog in de resultaten eindigen door deze websites te straffen of uit de resultaten te verbannen. Deze ‘penalties’ (straffen) kunnen zowel automatisch als handmatig toegepast worden.

Als een website een algoritmisch bepaalde penalty krijgt, kan deze website normaal gesproken na een bepaalde periode weer opgenomen worden in de zoekresultaten als het probleem verholpen is. Een website die een handmatige straf heeft gekregen, kan echter voor een langere periode uit de zoekresultaten verwijderd worden. Vaak moet de webmaster dan bij de zoekmachine een verzoek om heropname indienen.

Sommige websites worden daarnaast om verschillende redenen gefilterd.

Penguin-algoritme

Het Penguin-algoritme van Google is een algoritme dat websites met onnatuurlijke linkprofielen bestraft.

Met de lancering van het Penguin-algoritme stapte Google af van de focus op het gebruik van links bij het bestraffen van webpagina’s, doordat nu ook excessief gebruik van sleutelwoorden (het zogenaamde ‘keyword stuffing’) in beschouwing werd genomen. In eerste instantie werd het Penguin-algoritme gepresenteerd als een update die spam tegen moest gaan, maar na veel ‘false positives’ en daaropvolgende negatieve feedback gaf Google de naam Penguin aan de update. Normaal gesproken draait Google verschillende updates tegelijkertijd, zodat niet duidelijk is welke specifieke update problemen veroorzaakt voor een bepaalde website. Af en toe geeft Google wel een aantal waarschuwingen of handmatige straffen rond de tijd dat Penguin geüpdatet wordt.

Websites die door latere versies van Penguin bestraft werden, konden normaal gesproken weer na de eerstvolgende update van Penguin in de zoekresultaten opgenomen worden als de webmaster problemen met het linkprofiel van de website opgelost had in Search Console. Websites die echter door eerdere versies van Penguin bestraft werden, konden deze problemen veel moeilijker oplossen.

Pigeon-update

Een update van Google’s algoritmes voor lokale zoekresultaten, waarbij meer signalen geassocieerd met reguliere zoekopdrachten in beschouwing werden genomen.

Pingen

Het pingen van een link houdt in dat men aan de zoekmachines doorgeeft dat een bepaalde pagina geüpdatet is en dat deze opnieuw gecrawled moet worden. Je zegt dus als het ware tegen de zoekmachines: ‘Hey dit is een nieuwe pagina/er is wat veranderd op deze pagina, jullie zouden er goed aan doen om deze opnieuw te bekijken en op te nemen in jullie index.’ SEO partijen bieden dit vaak als dienst aan en doen dit om backlinks naar de website van de klant sneller te laten vinden door zoekmachines.

Piraterij-update

Een update van Google’s algoritmes die websites met veel copyrightschendingen lager in de zoekresultaten plaatste. YouTube en Blogspot zijn uitgezonderd van deze update.

Poison words

‘Poison words’ (giftige woorden) waren woorden die traditioneel met content van lage kwaliteit geassocieerd werden. Zoekmachines plaatsten webpagina’s waar deze woorden op stonden lager in de zoekresultaten.

Portal

Een portal is een website die bepaalde services aanbiedt zoals nieuws, e-mail, of andere content.

PPC

Pay Per Click is het prijsmodel van de meeste zoekmachine-advertenties en contextuele advertentieprogramma’s. PPC-advertenties factureren een adverteerder alleen als een potentiële klant op een advertentie klikt.

Q

QDF (Zoekterm Verdient Freshness)

Zoekterm verdient Freshness (Query Deserves Freshness) is een algoritmisch signaal gebaseerd op bijvoorbeeld een plotselinge klim in zoek-volume of meerdere nieuws publicaties over een onderwerp waardoor Google vind dat een specifieke zoekterm als recent/fresh aangemerkt moet worden.

Recent gepubliceerde content word soms gezien als fresh, maar oudere content word ook gezien als fresh als het recent geüpdate is, een plotselinge groei in lezers heeft ervaren, en/of de link velocity (de snelheid waarmee de hoeveelheid inkomende links groeit) plots omhoog gegaan is.

Query (Zoekterm)

De zoekterm zoals de gebruiker deze in een search engine invoert.

Query Refinement (Zoekterm verfijning)

Sommige gebruikers verfijnen hun zoekterm als ze vinden dat het resultaat niet relevant is. Sommige search engines proberen om specifieke geassocieerde termen te promoten, of andere zoektermen te suggereren als ze denken dat deze relevant zijn voor het doel van de gebruiker.

Zoekterm verfijning is zowel een handmatig als een geautomatiseerd proces. Als gebruikers vinden dat hun zoekresultaten niet relevant zijn kunnen ze het soms opnieuw proberen. Search engines kunnen ook automatisch zoektermen verfijnen met de volgende technieken:

• Google OneBox: promoot een verticale zoek database bovenaan het zoekresultaat. Bijvoorbeeld, als afbeeldingen relevant zijn voor je zoekterm kunnen afbeeldingen bovenaan geplaatst worden.

• Spellingcorrectie: bied een bedoelde je dit link aan met een gecorrigeerde spelling, bovenaan de zoekresultaten.

• Inline suggesties: bied gerelateerde zoekresultaten aan in de zoekresultaten. Sommige search engines suggereren ook een aantal gerelateerde zoektermen.

Sommige zoek-toolbars proberen ook gebruikers te helpen door hun zoekterm af te maken door een lijst met populaire zoektermen te suggereren die overeenkomen met de letters die de gebruiker al heeft ingevoerd.

R

Repeat Visits (Herhaal bezoeken)

Website bezoekers die die website in het recente verleden ook al bezocht hadden.

Search engines letten vaak op signalen zoals een toestroming van regelmatige herhaal bezoeken aan een site en veel merk-gerelateerde searches als een indicatie van sterke user engagement (gebruikers betrekking) waardoor ze de site hoger ranken in algoritmes zoals Panda. Sites die weinig herhaal bezoeken en merk-gerelateerde searches krijgen vergeleken met hun algehele zoek-verkeer kunnen gezien worden als zijnde van lagere kwaliteit en dus lager geranked worden.

Robots.txt

Een bestand dat in de root van een site zit en search engines verteld welke bestanden ze niet moeten crawlen (indexeren). Sommige search engines zullen je URLs nog steeds als URL only listings laten zien zelfs als je ze blokkeert met een robots.txt bestand. Plaats geen files op een publieke server als je niet wilt dat search engines ze indexeren!

S

SERP

De zoekmachine resultaten pagina is de pagina waarop de zoekpagina de resultaten van een zoekopdracht laat zien.

Site Map

Pagina die gebruikt kan worden om zoekmachines een secundaire route door uw site te geven.

Tips:

- Op grote websites moet de navigatie op de pagina zelf de zoekmachine helpen alle pagina’s te vinden.

- Op grote websites is het niet zinnig om iedere pagina op de site map te zetten, hou het bij de belangrijke pagina’s.

- Site maps kunnen gebruikt worden om Interne Link Autoriteit (Internal Link Authority) naar belangrijke pagina’s of secties te distribueren.

- Site maps kunnen andere, meer descriptieve anker tekst gebruiken dan andere secties van uw site om zoekmachines te helpen begrijpen waar uw pagina’s over gaan.

- Site maps moeten zo gemaakt worden dat ze ook nuttig zijn voor menselijke gebruikers, niet alleen zoekmachines.

Spider

Een zoekmachine crawler die het web doorzoekt of ‘spidert’ voor pagina’s om toe te voegen aan de index.

Veel non-traditionele zoekmachine bedrijven hebben verschillende spiders die andere taken uitvoeren. Bijvoorbeeld, TurnItInBot zoekt naar plagiaat. Spiders moeten altijd naar het robot.txt protocol luisteren.

Splog

Spam blog, bestaat typisch uit gestolen of geautomatiseerde inhoud die van lage kwaliteit is.

Server Side Includes

Is een methode om gedeeltes van een pagina in te roepen vanuit een andere pagina. SSI maakt het makkelijker om websites te updaten.

T

Taxonomie

Classificatie systeem met een gecontroleerd vocabulair dat gebruikt word om onderwerpen te rangschikken, vaak op een hiërarchische wijze.

Titel

Het titel element word gebruikt om een webpagina te beschrijven.

De titel is een van de meest belangrijke aspecten van SEO voor een webpagina. Iedere pagina titel moet:

- Uniek zijn voor de pagina: niet dezelfde titel voor iedere pagina op een website!

- Descriptief: welke belangrijke ideeën dekt de pagina?

- Niet te lang: meestal moeten pagina titels tussen de 8 en 10 woorden of minder zijn, met een aantal van de belangrijke woorden aan het begin van de titel.

Pagina titels verschijnen in zoekresultaten als de links waar gebruikers op klikken. Verder linken veel mensen naar documenten met de officiële documentstitel als link anker tekst. U krijgt dus met een descriptieve titel vaker descriptieve anker tekst, en het is dan waarschijnlijker dat er op uw link geklikt wordt.

In sommige gevallen is het ook handig om een titel te gebruiken die niet letterlijk descriptief is, maar makkelijk geassocieerd kan worden met menselijke emoties of een controverse zodat uw idee zich verder verspreid en meer mensen editorial links van hoge kwaliteit naar uw document sturen.

Er zijn twee hoofdwijzen om titels SEO vriendelijk te maken.

- Schrijf letterlijke titels die in lijn zijn met waar gebruikers naar zoeken.

- Schrijf pagina titel’s die erg aantrekkelijk zijn om naar te linken. Als genoeg mensen naar uw pagina’s linken dan zal uw site ranken voor veel relevante zoekopdrachten ook als de relevante sleutelwoorden niet in de pagina titel’s voorkomen.

Trackback

Geautomatiseerde notificatie dat een andere website uw site genoemd heeft. Trackbacks zijn bij veel populaire blog software programma’s ingebakken.

Vanwege de geautomatiseerde aard van trackbacks zijn ze vaak makkelijk te spammen. Veel publishers zetten trackbacks uit omdat er relatief weinig nuttige informatie uit komt.

TrustRank

Relevantie algoritme dat extra belang toedicht aan links vanuit vertrouwde websites die van bijvoorbeeld grote bedrijven, onderwijs instituten, of overheids instituten komen.

U

URL

Uniform Resource Locator, of Uniforme Bron Locatie, is het unieke adres dat ieder webdocument heeft.

Usability

Hoe makkelijk het is voor klanten om hun gewenste doel te bereiken.

De structuur en opbouw van tekst en hyperlinks gebaseerd op calls to action kan de bruikbaarheid van uw website drastisch verhogen, en daarmee conversion rates.

Usage Data

Dingen zoals grote toestroming van verkeer, een hoog percentage bezoekers als herhaal bezoekers, lange verblijfstijd, meerdere page views per bezoeker, een hoge doorklik rate, of een hoog niveau van merk-gerelateerde zoekopdrachten kunnen door sommige zoekmachines gezien worden als een teken van kwaliteit. Sommige zoekmachines gebruiken deze signalen om de rankings te verbeteren van documenten en websites van hoge kwaliteit via algoritmes zoals Panda.

V

Vertical Search

Een zoekdienst die gefocust is op een specifiek onderwerp, een specifiek type informatie, of een specifiek format.

Bijvoorbeeld, Business.com is een B2B verticale zoekmachine, en Youtube is een op video’s gebaseerde verticale zoekmachine.

W

Whois

Ieder domein heeft een eigenaar. Eigendomsgegevens zijn opgeslagen in de Whois records van dit domein. Sommige domein registrars geven de mogelijkheid om de eigendomsgegevens van jouw sites te verbergen. Veel grootschalige spammers gebruiken nep Whois gegevens.

White Hat SEO

Zoekmachines hebben richtlijnen om miljarden dollars uit advertenties te halen van het werk van uitgevers en van de aandacht van searchers. Binnen dit enorme winstgevende kader beschouwen zoekmachines bepaalde marketing technieken van nature bedrieglijk en krijgen ze het label black hat SEO. De technieken die binnen hun richtlijnen vallen worden white hat SEO technieken genoemd. De zoekmachine richtlijnen zijn geen statische regels, en zaken die de ene dag nog geoorloofd zijn kunnen de volgende dag als bedenkelijk worden beschouwd.

Wiki

Software die informatie publiceert met gebruik van collaborative editing.

Wikipedia

Gratis online collaborative encyclopedie, die gebruik maakt van wiki software.

X

XHTML

Extensible HyperText Markup Language is een reeks specificaties ontworpen om HTML zo te wijzigen dat het zich aanpast aan de XML opmaak.

XML

Extensible Markup Language is een simpele, erg flexibele text format die afstamt van SGML, wat werd gebruikt om het verzamelen of opmaken van informatie te vergemakkelijken met gebruik van technologie zoals RSS.

Y

Yahoo!

Internet portal bedrijf die met het populaire Yahoo! Directory was begonnen.

Yahoo! Directory

Een van de oorspronkelijke, meest populaire, en nu de meest gezaghebbende web directories, opgestart door David Filo en Jerry Yang in 1994. De Yahoo! Directory is een van de weinige plekken waar bijna iedere legale site een betrouwbare link kan krijgen. Alhoewel $299 per jaar duur lijkt voor een aantal kleine ondernemingen, met een Yahoo! Directory link zal je positie in grote zoekmachines stijgen.

Z

Zeal

Niet-commerciële directory die door Looksmart was gekocht voor $20 miljoen, toen ineens stopte met weinig tot geen waarschuwing.

Zone

Bij sommige zoekmachines kan je een zoekopdracht beperken tot specifieke zones – beter omschreven als onderwerpen. Een gebruiker kan, bijvoorbeeld, ervoor kiezen om alleen documenten uit een bepaald geografisch gebied te zoeken of alleen documenten die binnen een bepaald tijdbestek zijn gecreëerd.

Uiteraard draai ik ook op verzoek. Mis je een bepaalde term? Laat het me weten via het contactformulier en/of de Live Chat. Zal jouw vraag zo spoedig mogelijk beantwoorden en de term/concept/theorie eventueel toevoegen aan de kennisbank.